Regola 68-95-99,7

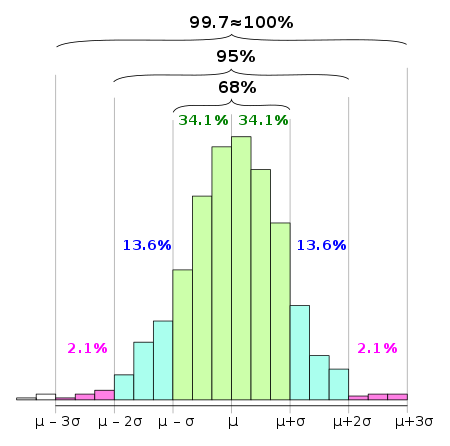

In statistica, la regola 68-95-99,7, nota anche come regola empirica, è un'abbreviazione utilizzata per ricordare la percentuale di valori che si trovano all'interno di una banda attorno alla media in una distribuzione normale con un'ampiezza di due, quattro e sei deviazioni standard, rispettivamente; più precisamente, il 68,27%, il 95,45% e il 99,73% dei valori si trovano rispettivamente all'interno di una, due e tre deviazioni standard della media.

Nella notazione matematica, questi concetti possono essere espressi come segue, dove Χ è un'osservazione da una variabile casuale con distribuzione normale, μ è la media della distribuzione e σ è la sua deviazione standard:

Nelle scienze empiriche la cosiddetta regola empirica dei tre sigma esprime un'euristica convenzionale secondo cui quasi tutti i valori sono considerati entro tre deviazioni standard della media, e quindi è empiricamente utile trattare la probabilità del 99,7% come quasi certezza.[1]

L'utilità di questa euristica dipende soprattutto dalla questione in esame. Nelle scienze sociali, un risultato può essere considerato significativo se il suo livello di confidenza è dell'ordine di un effetto due sigma (95%), mentre nella fisica delle particelle per motivi teorici si necessita di un effetto cinque sigma (99,99994% livello di confidenza) per qualificare una scoperta.

Una regola dei tre sigma più debole può essere derivata dalla disuguaglianza di Chebyshev, affermando che anche per variabili non distribuite normalmente, almeno l'88,8% dei casi dovrebbe rientrare in intervalli di tre sigma correttamente calcolati. Per le distribuzioni unimodali, la probabilità di essere all'interno dell'intervallo è almeno del 95% secondo la disuguaglianza di Vysochanskij-Petunin. Ci possono essere alcune ipotesi per una distribuzione che forzano questa probabilità ad essere almeno del 98%.[2][3]

Funzione di distribuzione cumulativa modifica

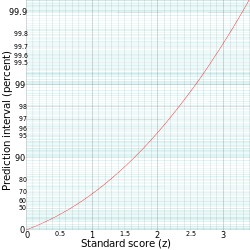

Questi valori numerici "68%, 95%, 99,7%" derivano dalla funzione di distribuzione cumulativa della distribuzione normale.

L'intervallo di predizione per qualsiasi punteggio standard corrisponde numericamente a .

Ad esempio, oppure , corrispondente a un intervallo di predizione di .

Questo non è un intervallo simmetrico: è semplicemente la probabilità che un'osservazione sia inferiore a . Per calcolare la probabilità che un'osservazione si trovi entro due deviazioni standard della media (piccole differenze dovute all'arrotondamento):

Ciò è correlato all'intervallo di confidenza utilizzato nelle statistiche: è circa un intervallo di confidenza del 95% dove è la media di un campione di dimensioni .

Test di normalità modifica

La "regola 68-95-99,7" viene spesso utilizzata per ottenere rapidamente una stima approssimativa della probabilità di qualcosa, data la sua deviazione standard, se si presume che la popolazione sia normale. Viene anche utilizzato come semplice test per i valori anomali se la popolazione è considerata normale e come test di normalità se la popolazione è potenzialmente non normale.

Per passare da un campione a un numero di deviazioni standard, si calcola prima la deviazione, l'errore o il residuo a seconda che si conosca la media della popolazione o la si stimi soltanto. Il passo successivo è la standardizzazione (dividendo per la deviazione standard della popolazione), se i parametri della popolazione sono noti, o la studentizzazione (dividendo per una stima della deviazione standard), se i parametri sono sconosciuti e solo stimati.

Per utilizzarla come test per valori anomali o test di normalità, si calcola la dimensione delle deviazioni in termini di deviazioni standard e la si confronta con la frequenza prevista. Dato un insieme di campioni, è possibile calcolare i residui studentizzati e confrontarli con la frequenza attesa: i punti che cadono per più di 3 deviazioni standard dalla norma sono probabilmente valori anomali (a meno che la dimensione del campione non sia significativamente estrema), e se ci sono molti punti con più di 3 deviazioni standard dalla norma, è probabile che si abbia motivo di mettere in dubbio la presunta normalità della distribuzione. Questo vale a maggior ragione per discostamenti di 4 o più deviazioni standard.

Si può calcolare in modo più preciso, approssimando il numero di discostamenti estremi di una data grandezza o maggiore da una distribuzione di Poisson: semplicemente, se si hanno più 4 discostamenti di deviazione standard in un campione di dimensione 1000, si ha una buona ragione per considerare questi valori anomali o mettere in dubbio la presunta normalità della distribuzione.

Ad esempio, un evento 6σ corrisponde a una possibilità di circa due parti per miliardo. Ciò significa che se gli eventi ordinari si verificassero con cadenza quotidiana, vi sarebbe un evento anomalo previsto ogni 1,4 milioni di anni. Da questo si ricava un semplice test di normalità: se si osserva un 6σ nei dati giornalieri e sono trascorsi significativamente meno di 1 milione di anni, è molto probabile che l'ampiezza o la frequenza di notevoli deviazioni da quanto osservato non possano essere spiegate dal modello considerato per una distribuzione normale.

Nel saggio Il cigno nero, Nassim Nicholas Taleb fornisce l'esempio di modelli di rischio secondo i quali il crollo del lunedì nero del 1987 corrisponderebbe a un evento di 36σ: il verificarsi di un tale evento dovrebbe immediatamente suggerire che il modello è difettoso, cioè che il processo in esame non è modellizzato in modo soddisfacente da una distribuzione normale. Si dovrebbero quindi considerare modelli raffinati, ad esempio mediante l'introduzione della volatilità stocastica. In questi studi è importante essere consapevoli del problema dell'errore dello scommettitore, che afferma che una singola osservazione di un evento raro non contraddice il fatto che l'evento sia in realtà raro. È l'osservazione di una pluralità di eventi presumibilmente rari che mina sempre più l'ipotesi che siano effettivamente rari, ovvero la validità del modello assunto. Una corretta modellizzazione di questo processo di graduale perdita di fiducia in un'ipotesi comporterebbe la necessità di calcolare la probabilità a priori non solo dell'ipotesi stessa ma anche di tutte le possibili ipotesi alternative. Per questo motivo, la verifica delle ipotesi statistiche funziona non tanto confermando un'ipotesi ritenuta probabile, quanto confutando ipotesi ritenute improbabili.

Tabella dei valori numerici modifica

A causa delle code esponenziali della distribuzione normale, le probabilità di deviazioni maggiori diminuiscono molto rapidamente. Dalle regole per i dati normalmente distribuiti per un evento quotidiano:

| Gamma | Frazione prevista di popolazione all'interno dell'intervallo | Frequenza prevista approssimativa al di fuori dell'intervallo | Frequenza approssimativa per evento quotidiano | |||

|---|---|---|---|---|---|---|

| μ ± 0,5σ | 0,382 924 922 548 026 | 3 ogni | 5 | Quattro o cinque volte a settimana | ||

| μ ± σ | 0,682 689 492 137 086 | 1 ogni | 3 | Due volte a settimana | ||

| μ ± 1,5σ | 0,866 385 597 462 284 | 1 ogni | 7 | settimanalmente | ||

| μ ± 2σ | 0,954 499 736 103 642 | 1 ogni | 22 | Ogni tre settimane | ||

| μ ± 2,5σ | 0,987 580 669 348 448 | 1 ogni | 81 | Trimestrale | ||

| μ ± 3σ | 0,997 300 203 936 740 | 1 ogni | 370 | Annuale | ||

| μ ± 3,5σ | 0,999 534 741 841 929 | 1 ogni | 2149 | Ogni 6 anni | ||

| μ ± 4σ | 0,999 936 657 516 334 | 1 ogni | 15787 | Ogni 43 anni (due volte nella vita) | ||

| μ ± 4,5σ | 0,999 993 204 653 751 | 1 ogni | 147160 | Ogni 403 anni (una volta nell'era moderna) | ||

| μ ± 5σ | 0,999 999 426 696 856 | 1 ogni | 1744278 | Ogni 4776 anni (una volta nella storia documentata) | ||

| μ ± 5,5σ | 0,999 999 962 020 875 | 1 ogni | 26330254 | Ogni 72090 anni (tre volte nella storia dell'umanità moderna) | ||

| μ ± 6σ | 0,999 999 998 026 825 | 1 ogni | 506797346 | Ogni 1,38 milioni di anni (due volte nella storia dell'umanità) | ||

| μ ± 6,5 σ | 0,999 999 999 919 680 | 1 ogni | 12450197393 | Ogni 34 milioni di anni (due volte dall'estinzione dei dinosauri) | ||

| μ ± 7σ | 0,999 999 999 997 440 | 1 ogni | 390682215445 | Ogni 1,07 miliardi di anni (quattro occorrenze nella storia della Terra) | ||

| μ ± x σ | 1 ogni | Ogni giorni | ||||

Note modifica

- ^ Questo utilizzo della 'regola dei tre sigma' è entrato in uso comune negli anni 2000, ad esempio citato in Schaum's Outline of Business Statistics, McGraw Hill Professional, 2003, p. 359.

- ^ (EN) Donald J. Wheeler e David Smith Chambers, Understanding Statistical Process Control, SPC Press, 1992, ISBN 978-0-945320-13-5. URL consultato il 29 novembre 2020.

- ^ Friedrich Pukelsheim, The Three Sigma Rule, in The American Statistician, vol. 48, n. 2, 1994-05, p. 88, DOI:10.2307/2684253. URL consultato il 29 novembre 2020.

Voci correlate modifica

Altri progetti modifica

- Wikimedia Commons contiene immagini o altri file sulla regola 68-95-99,7

Collegamenti esterni modifica

- The Normal Distribution di Balasubramanian Narasimhan

- Calcola la proporzione percentuale entro x sigma su WolframAlpha